Hyperscale

Testanforderungen, -ressourcen und -lösungen

Hyperscale-Ökosysteme und VIAVI

VIAVI Solutions arbeitet in mehr als 30 Standardisierungsgremien und Open-Source-Initiativen, wie dem Telecom Infra Project (TIP), aktiv mit. Sollten sich neue Standards jedoch verzögern, gehen wir auch voran und entwickeln Messtechnik, die zukünftige Infrastruktur-Normen bereits berücksichtigt. Wir fördern offene Anwendungsprogrammierschnittstellen (API), damit Hyperscale-Unternehmen weiter eigene Automatisierungscodes schreiben können.

Aufgrund der Komplexität der Hyperscale-Architektur kann beim Aufbau, bei der Erweiterung und bei der Überwachung dieser Netze nicht auf entsprechende Tests verzichtet werden. Jahrzehnte der Innovation, Partnerschaft und Kooperation mit mehr als 4.000 weltweit agierenden Kunden und mit Standardisierungsgremien, wie der FOA, versetzen VIAVI in die beispiellose Lage, die Herausforderungen, mit denen die Hyperscaler bei der Testausführung und der Assurance ihrer Systeme konfrontiert sind, zu bewältigen. VIAVI garantiert die Leistung der optischen Hardware über den gesamten Lebenszyklus des Rechenzentrum(RZ)-Ökosystems, angefangen beim Labor über die Aktivierung bis zur Überwachung.

Was bedeutet „Hyperscale“?

Der Begriff „Hyperscale“ bezeichnet eine Hardware- und Software-Architektur, die genutzt wird, um hochanpassungsfähige Rechnersysteme mit einer großen Anzahl von vernetzten Servern zu schaffen. Die von der International Data Corporation (IDC) verwendete Definition geht von mindestens 5.000 Servern aus, die eine Grundfläche von 930 Quadratmetern und mehr einnehmen.

Mit horizontaler Skalierung (Scaling-out) kann flexibel auf eine steigende Nachfrage reagiert werden, indem mehr Server aufgestellt oder aktiviert werden. Demgegenüber erhöht die vertikale Skalierung (Scaling-up) die Leistung, Geschwindigkeit und Bandbreite vorhandener Hardware. Die von der Hyperscale-Technologie bereitgestellte große Kapazität bietet sich für Cloud-Computing und Big-Data-Anwendungen an. Eine weitere wichtige Komponente sind softwaredefinierte Netzwerke (SDN) mit spezieller Lastverteilung, um den Verkehr zwischen den Servern und Clients ausgeglichen zu übertragen.

Hyperscale-Ressourcen

- Wie funktioniert Hyperscale?

Hyperscale-Lösungen optimieren die Hardware-Effizienz durch sehr große Serversysteme und Rechenprozesse, die die Flexibilität und Skalierbarkeit fördern. Der Lastverteilungsmechanismus (Load Balancer) überwacht kontinuierlich die Verkehrslast und Kapazität der einzelnen Server, sodass neue Anfragen ordnungsgemäß weitergeleitet werden. Künstliche Intelligenz (KI) kann für die Hyperscale-Speicherung, die Lasterteilung und die glasfaserbasierte Übertragung genutzt werden, um die Leistung zu optimieren und im Leerlauf betriebene oder nicht ausgenutzte Serverkapazitäten abzuschalten. - Hyperscale-Vorteile

Die Hyperscale-Architektur bietet allein aufgrund ihrer Größe bereits mehrere Vorteile. Dazu zählen die effiziente Kühlung und Energieverteilung, die Lastverteilung zwischen den Servern sowie die integrierte Redundanz. Diese Leistungsmerkmale erleichtern auch das Speichern, Lokalisieren und Backup großer Datenmengen. Es kann für Unternehmen wirtschaftlicher sein, die Dienstleistungen von Hyperscale-Anbietern in Anspruch zu nehmen, als eigene Server zu kaufen, zu pflegen und mit dem Risiko von Ausfallzeiten leben zu müssen. Damit kann sich auch die Belastung des eigenen IT-Personals verringern. - Hyperscale-Herausforderungen

Die von der Hyperscale-Technologie gebotenen Größenvorteile können aber auch neue Herausforderungen hervorbringen. So ist es möglich, dass die großen Verkehrsvolumen und die komplexen Datenflüsse die Echtzeitüberwachung erschweren. Auch wird die Sichtbarkeit externer Verkehrsflüsse eventuell durch die Geschwindigkeit und die Anzahl der vorhandenen Glasfasern und Anschlüsse beeinträchtigt. Da die hohe Konzentration der Daten auch die Auswirkungen eventueller Sicherheitsverletzungen verschärften, verstärken sich entsprechende Sicherheitsbedenken. Automatisierung und maschinelles Lernen (ML) sind zwei Tools, die den Hyperscale-Anbietern zur Verfügung stehen, um die Beobachtbarkeit und Sicherheit zu verbessern.

Hyperscale-Modelle

Mit der Fähigkeit, die Arbeitsspeicher, Speicherkapazitäten und Rechenleistungen exakt an sich verändernde Anforderungen anpassen zu können, unterscheidet sich die Hyperscale-Architektur von traditionellen Rechenzentren. Virtuelle Maschinen (VM) ermöglichen, Software-Anwendungen schnell von einem physischen Standort zum nächsten zu übertragen. Hochdichte Server, parallele Knoten (Nodes) zur Verbesserung der Redundanz sowie die kontinuierliche Überwachung sind weitere weitverbreitete Leistungsmerkmale. Da jede Architektur oder Server-Konfiguration auch Schwächen aufweist, entstehen immer wieder neue Modelle, die den sich weiter entwickelnden Anforderungen der Netzbetreiber, Serviceprovider und Kunden besser gerecht werden.

- Was ist Hyperscale-Cloud?

Das Internet und Cloud-Computing haben neue Maßstäbe für den Zugriff der Benutzer auf Anwendungen und Datenspeicher gesetzt. Mit der Übertragung dieser Funktion von lokalen Servern auf externe Rechenzentren (RZ), die von großen Cloud-Serviceprovidern (CSP) betrieben werden, können Unternehmen die Infrastruktur bedarfsgerecht vergrößern, ohne die eigenen internen Abläufe zu beeinträchtigen. Hyperscale-Cloud-Anbieter erweitern das traditionelle Cloud-Angebot von u. a. Software-as-a-Service (SaaS), Infrastructure-as-a-Service (IaaS) und Datenanalysen um eine weitaus größere RZ-Kapazität und Elastizität. - Vergleich von Hyperscale und Cloud-Computing

Auch wenn diese Begriffe zuweilen gleichbedeutend verwendet werden, erreichen Cloud-Installationen nicht immer diese riesigen Ausmaße. Zudem unterstützen Hyperscale-Rechenzentren viel mehr als nur Cloud-Computing. Öffentliche Clouds, die mehreren Kunden über das Internet bestimmte Ressourcen bereitstellen (Cloud-as-a-Service) gelten häufig als Hyperscale, während private Cloud-Systeme recht klein sein können. Wenn ein Rechenzentrum, das von einem einzelnen Unternehmen nur für dessen eigenen Rechen- und Speicherbedarf gebaut und betrieben wird, eine große Server-Anzahl und erweiterte Managementfunktionen bietet, spricht man von einem Enterprise-Hyperscale. - Hyperscale-Cloud-Anbieter

Hyperscale-Cloud-Anbieter tätigen große Investitionen in die Infrastruktur und in geistiges Eigentum (IP), um die Anforderungen ihrer Kunden zu erfüllen. Die Interoperabilität wird immer wichtiger, da die Kunden an einer Übertragbarkeit (Portabilität) über standardisierte Plattformen hinweg interessiert sind. Untersuchungen der Synergy Research Group zeigen, dass die drei größten Player, d. h. Amazon Web Services (AWS), Microsoft und Google, mehr als die Hälfte der Installationen besitzen. Diese drei Anbieter unternehmen auch die größten Planungs- und Entwicklungsanstrengungen für Hyperscale-Edge-RZ, die benötigt werden, um den wachsenden Anforderungen der 5G-Technologie und des Internet der Dinge (IoT) gerecht zu werden. - Hyperscale-Colocation

Das Colocation-Konzept ermöglicht einem Unternehmen, einen Teil eines bestehenden Rechenzentrum zu mieten, anstatt selbst ein neues RZ zu bauen. Hyperscale-Colocation kann nützliche Synergien freisetzen, wenn verwandte Branchen, wie Einzel- und Großhandel, unter einem Dach arbeiten. Für die einzelnen Mieter sinken die Gesamtkosten für Energie, Kühlung und Kommunikation, während sich die Verfügbarkeit, Sicherheit und Skalierbarkeit deutlich verbessern. Hyperscale-Unternehmen können ihre Effizienz und Rentabilität verbessern, indem sie überschüssige Kapazitäten an Interessenten vermieten. - Hyperscale-Architektur

Obgleich die Hyperscale-Architektur nicht eindeutig definiert ist, gelten eine Speicherkapazität von mindestens 1 Petabyte, eine diskrete Software-Layer für komplexe Lastverteilungs- und Datenübertragungsfunktionen, integrierte Redundanz sowie Standardserver als Erkennungsmerkmale. Im Unterschied zu den Servern der kleinen privaten Rechenzentren, nutzen die Hyperscale-Server zumeist breitere Racks und sind für eine einfachere Neukonfiguration ausgelegt. Diese Kombination von Leistungsmerkmalen verlagert die Intelligenz von der Hardware zu einer umfassenderen Software und Automatisierung, um die Datenspeicherung und Anwendungsskalierung schnellstmöglich zu realisieren. - Vergleich von Hyperscale und Hyperconverged

Im Unterschied zu Hyperscale-Architekturen, die die Rechenfunktion von der Speicherung und Vernetzung trennen, integrieren Hyperconverged-Architekturen diese Komponenten in fertige modulare Lösungen. Mit softwaredefinierten Elementen, die in einer virtuellen Umgebung erstellt werden, sind die oben genannten drei Komponenten (Computing, Speicherung, Vernetzung) eines Hyperconverged-Systems untrennbar miteinander verbunden. Die Hyperconverged-Architektur erleichtert das Up-/Down-Scaling über einen zentralen Kontaktpunkt. Weitere Vorteile sind die gebündelten Komprimierungs-, Verschlüsselungs- und Redundanzfunktionen.

Hyperscale-Konnektivität

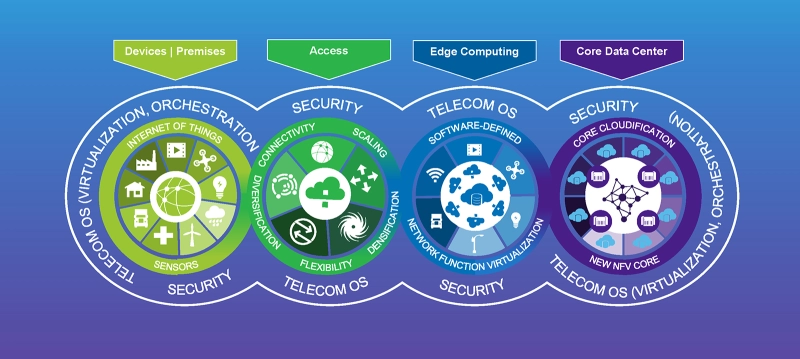

Da Hyperscale-Modelle eine immer stärkere Verteilung aufweisen, sind auch Edge-Computing- und Multi-Cloud-Strategien häufiger anzutreffen. Hier gilt es, eine reibungslose Konnektivität sowohl der physischen Anschlüsse innerhalb des Rechenzentrums als auch der Highspeed-Glasfaserstrecken, die mehrere Hyperscale-Standort zusammenschalten, zu gewährleisten.

- Data Center Interconnect (DCI) bezeichnet die Zusammenschaltung von Rechenzentrum sowie die weltweite Verbindung intelligenter Edge-Computing-Zentren.

- DCI-Verbindungstests erleichtern die Installation durch die schnelle Überprüfung des Durchsatzes und die präzise Lokalisierung von Latenzstörungen und anderen Problemen.

- PAM4-Modulation und Vorwärtsfehlerkorrektur (FEC) erhöhen die Komplexität der Highspeed-DCI-Verbindungen von Ethernet 400G/800G.

Die automatische und sekundenschnelle visuelle Inspektion von MPO-Verbindern, das simultane Testen mehrerer 400G-/800G-Anschlüsse sowie die Aktivierung und Überwachung virtueller Dienste gehören zu den Testanforderungen, die bewältigt werden müssen, um mit der sich entwickelnden Hyperscale-Interconnect-Architektur Schritt halten zu können.

Hyperscale-Testverfahren

Viele Hyperscale-Testverfahren zur Überprüfung von Glasfaseranschlüssen, der Netzwerkleistung und der Dienstgüte (QoS) sind mit denen in konventionellen Rechenzentren identisch – sie sind lediglich in viel größerem Umfang erforderlich. Die Bedeutung einer zuverlässigen Verfügbarkeit steigt noch mit der Komplexität der Tests. Bis fast an die Leistungsgrenze belastete DCI-Verbindungen sollten durchgängig getestet und überwacht werden, um den Durchsatz zu überprüfen und potenzielle Störungen zu erkennen, noch bevor es zu einem Ausfall kommen kann. Um die Ressourcenbelastung weitestgehend zu verringern, sollten zudem automatische Überwachungslösungen eingesetzt werden.

Aufgrund der kundenspezifischen Anpassungen der Hardware und Software in den Rechenzentren müssen Premium-Testlösungen eine umfassende Interoperabilität gewährleisten. Dazu gehören Tester, die offene APIs unterstützen, um die Hyperscale-Vielseitigkeit zu berücksichtigen. Gängige Schnittstellen wie PCIe und MPO, die eine hohe Dichte und Kapazität ermöglichen, finden immer weiter Verbreitung und erfordern zuverlässige Lösungen für effiziente Tests und ein reibungsloses Management.

- Bitfehlertester wie die Plattform MAP-2100 wurden speziell für Standorte entwickelt, an denen wenig oder kein Personal vorhanden ist, um manuelle Tests an den Netzwerken durchzuführen.

- Netzwerk-Überwachungslösungen für das Hyperscale-Ökosystem ermöglichen, über mehrere physische oder virtuelle Zugangspunkte flexibel umfassende Leistungsmessungen auszulösen.

- Beste Vorgehensweisen zum Testen ausgewählter Komponenten, wie von MPO-Verbindern und Faserbändchen, können im Rahmen der Installation sicher angewendet werden.

Hyperscale-Lösungen

Die Rechenzentren werden immer größer, komplexer und weisen natürlich auch eine höhere Dichte auf. Testlösungen und -produkte, die ursprünglich für andere kapazitätsintensive Glasfaser-Anwendungen entwickelt wurden, können genutzt werden, um Hyperscale-Systeme zu überprüfen und zu warten.

- Sichtprüfung von Faserendflächen: Die große Anzahl von optischen Anschlüssen und Verbindungen in und zwischen Rechenzentren erfordert zuverlässige und effiziente Tools zur Sichtprüfung von Faserendflächen. Schon der kleinste Fremdkörper, Defekt oder eine verunreinigte Endfläche kann die Einfügedämpfung (IL) unzulässig erhöhen und die Leistung im gesamten Netzwerk beeinträchtigen. Die besten Tools zur Faserendflächenprüfung bei Hyperscale-Anwendungen kombinieren eine kompakte Bauweise mit automatischen Prüfroutinen und der Unterstützung von Mehrfaserverbindern (MPO).

- Glasfaser-Überwachung: Die zunehmende Nutzung von Glasfaserkabeln für Hyperscale-Rechenzentren hat die Glasfaser-Überwachung zu einer komplizierten, aber kritischen Aufgabe werden lassen. Vielseitige Tester, die den Durchgang, die optische Dämpfung und den Leistungspegel überprüfen sowie OTDR-Messungen durchführen, sind unverzichtbar geworden. Diese Herausforderung stellt sich in allen Phasen des Aufbaus, der Inbetriebnahme und der Fehlerdiagnose des optischen Netzes. Automatische Glasfaser-Überwachungssysteme wie das optische Fernüberwachungssystem (RFTS) ONMSi gewährleisten ein skalierbares, zentrales Monitoring mit sofortiger Alarmauslösung.

- MPO-Mehrfaserverbinder: Früher wurden Multi-Fiber-Push-On(MPO)-Verbinder hauptsächlich für Trunkkabel mit hoher Faserzahl verwendet. Heute hat die hohe Belegungsdichte in Hyperscale-Systemen dazu geführt, dass die MPO-Schnittstelle sehr schnell auch für Patchfelder, Server und Switche übernommen wurde. Die visuelle Inspektion der MPO-Faserendflächen und das Testen der Glasfasern kann mithilfe spezialisierter MPO-Testlösungen mit automatischer Gut-/Schlecht Bewertung beschleunigt werden.

- Highspeed-Transport bei 400G und 800G: Neue Technologien, wie IoT und 5G mit ihren hohen Bandbreitenanforderungen haben dazu geführt, dass Ethernet-Highspeed-Standards wie 400G und 800G für Hyperscale-Lösungen unverzichtbar wurden. Skalierbare, automatische Tester führen erweiterte Fehlerraten- und Durchsatzmessungen aus, um die Leistung zuverlässig nachzuweisen. Aktivierungen gemäß den Branchenstandards Y.1564 und RFC 2544 bewerten bei diesen hohen Datenraten ebenfalls Latenz, Jitter und Rahmenverlust.

- Virtuelle Tests: Tests, für deren Durchführung früher ein Netzwerktechniker zum Einsatzort fahren musste, können heute über den Test-Agenten Fusion virtuell ausgeführt werden, um Ressourcen zu sparen. Die softwarebasierte Plattform Fusion kann genutzt werden, um Netzwerke zu überwachen und die Einhaltung von Dienstgütevereinbarungen (SLA) zu kontrollieren. Zudem ist es möglich, TCP-Durchsatzmessungen wie RFC 6349 und andere Tests zur Ethernet-Aktivierung virtuell zu starten und durchzuführen.

- 5G-Netze: Verteilte, disaggregierte 5G-Netze erhöhen die Anforderungen an Hyperscale-Lösungen und die Ausführung von virtuellen Tests an den Funktionen, Anwendungen und Sicherheitsmaßnahmen im Netzwerk. Die Lösung TeraVM ist ein wertvolles Hilfsmittel zum Validieren sowohl der physischen als auch der virtuellen Netzwerkfunktionen und zum Emulieren von Millionen von Anwendungsdatenströmen, um die allgemeine Erlebnisqualität (QoE) zuverlässig zu bewerten. Erfahren Sie mehr über die lückenlosen RANtoCore™-Ende-zu-Ende-Lösungen zum Testen und Validieren.

- Beobachtbarkeit: Das Konzept der Beobachtbarkeit zielt darauf ab, tiefere Einblicke in das Netzwerk zu gewinnen, die dann zu einer höheren Leistung und Zuverlässigkeit führen. Die Plattform Observer von VIAVI nutzt wichtige Datenquellen im Netzwerk, um flexible, intuitive Dashboards und verwertbare Einblicke zu produzieren. Auf dieser Grundlage sind eine schnellere Problemlösung, eine verbesserte Skalierung und eine optimierte Bereitstellung der Dienste möglich. Erfahren Sie mehr über Leistungsmanagement und Sicherheit.

Angebotsspektrum

Das breite Spektrum der von VIAVI angebotenen Prüf- und Messtechnik deckt alle Aspekte und Phasen des Aufbaus, der Inbetriebnahme und der Wartung von Hyperscale-Systemen ab. Beim Übergang zu größeren und dichter belegten Rechenzentren und zum Edge-Computing bleibt die Sichtprüfung der Faserendflächen ein kritischer Bestandteil der Teststrategie.

- Zertifizierung: Angesichts der rasanten Verbreitung von MPO-Anschlüssen erweist sich das Faserprüfmikroskop INX 760 Probe Microscope als ideale Lösung für die automatische Zertifizierung der Faserendflächen von Mehrfaserverbindern. Optische Dämpfungsmessplätze (OLTS), die speziell für MPO-Verbinder entwickelt wurden, wie der SmartClass Fiber MPOLx, erleichtern die zuverlässige Tier-1-Faserzertifizierung.

- Highspeed-Test: Tests an optischen Transportnetzen (OTN) und die Aktivierung von Ethernet-Diensten müssen schnell und präzise durchgeführt werden, um den Anforderungen der Highspeed-Verbindungen in Hyperscale-Systemen gerecht zu werden:

- Der MTS 5800 100G ist ein branchenführender, robuster und kompakter 100G-Tester mit zwei Ports für Glasfasertests, die Aktivierung von Diensten und die Fehlerdiagnose. Dieses vielseitige Produkt bietet sich für Anwendungen im Metro- und Kernnetz sowie für DCI-Tests an.

- Zudem fördern die reproduzierbaren Messmethoden und -verfahren des MTS-5800 eine einheitliche Testausführung.

- Der vielseitige und cloudfähige OneAdvisor-1000 setzt neue Maßstäbe für Highspeed-Tests, da er alle Datenraten und Protokolle berücksichtigt, native PAM4-Konnektivität bietet und die Aktivierung von 400G-Diensten sowie Vorläufertechnologien testet.

- Mehrfaser-Komplettlösung: Hyperscale-Architekturen sind ein ideales Einsatzgebiet für automatische OTDR-Tests über MPO-Verbinder. Das MPO-Schaltmodul wurde mit dem Ziel entwickelt, eine Komplettlösung für hochdichte MPO-Glasfaserumgebungen zu schaffen. In Verbindung mit der Testplattform MTS können die Glasfasern jetzt ohne zeitaufwändige Fanout-/Breakout-Kabel über den OTDR-Anschluss charakterisiert werden. So ist es möglich, an bis zu 12 Glasfasern gleichzeitig automatische Zertifizierungstests auszuführen.

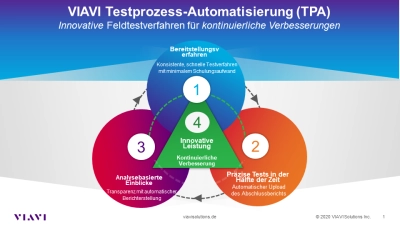

Automatische Tests: Die Testprozess-Automatisierung (TPA) verringert den Zeitaufwand für den Aufbau von Hyperscale-Architekturen, für manuelle Testabläufe und für Schulungen. Die Automatisierung ermöglicht effiziente Durchsatz- und BER-Tests zwischen Hyperscale-Rechenzentren sowie die Ende-zu-Ende-Verifizierung komplexer Network-Slices von 5G-Netzen.

- Der optische Dämpfungsmessplatz SmartClass Fiber MPOLx wendet mit seiner nativen MPO-Konnektivität, den automatischen Abläufen und der vollen Sichtbarkeit beider Faserenden die TPA auf die Tier-1-Zertifizierung von Glasfasern an. In weniger als sechs Sekunden werden umfassende Testergebnisse für 12 Glasfasern ausgegeben.

- Mit dem handlichen Glasfaser-Messgerät Optimeter wird kein Test mehr vergessen, da es alle Messungen, die für die Zertifizierung einer Glasfaserstrecke benötigt werden, in weniger als 1 Minute auf Tastendruck vollautomatisch ausführt.

- Autonome Glasfaser-Fernüberwachung: Moderne Ferntestlösungen bieten sich für skalierbare, unbemannte Hyperscale-Cloud-Umgebungen an. Das Glasfaser-Monitoring mit dem alarmiert den Anwender bei spezifischen Ereignissen, wie Qualitätsverschlechterungen, angezapften Fasern oder unberechtigten Zugriffen, und trägt dazu bei, die Einhaltung von Dienstgütevereinbarungen (SLA) und die DCI-Verfügbarkeit zu gewährleisten. Das Glasfaser-Fernüberwachungssystem ONMSi führt laufend OTDR-Erfassungsmessungen aus, um sich entwickelnde Leistungsmängel auf der Glasfaser zu erkennen und vorherzusagen. So ist es möglich, die Betriebsausgaben (OpEx), die Reparaturdauer (MTTR) sowie die Ausfallzeiten im Hyperscale-Rechenzentrum drastisch zu senken.

- Beobachtbarkeit und Validierung: Die gleichen Durchbrüche auf den Gebieten des maschinellen Lernens (ML), der künstlichen Intelligenz (KI) und der Virtualisierung der Netzwerkfunktionen (NFV), die bereits Hyperscale-Cloud- und Edge-Computing für 5G ermöglicht haben, fördern auch erweiterte Hyperscale-Testlösungen.

- Die Plattform Observer geht über die traditionelle Überwachung hinaus, da sie angereicherte Datenflüsse (Enriched Flow) und Verkehrsdaten der Konversationen intelligent in Echtzeit-Statusbewertungen und aussagekräftige Bewertungen (Scoring) des Endnutzererlebnisses einbindet.

Die flexible Software-Lösung TeraVM ist ideal zum Validieren von virtualisierten Netzwerkfunktionen geeignet. Wichtige Netzsegmente, wie Access, Mobilfunk-Backhaul und Sicherheit, können umfassend im Labor, im Rechenzentrum und in der Cloud validiert werden.

Anwendungsbeschreibungen

Broschüren

Fallstudie (Case Study)

Poster

Whitepaper und Bücher

Wir helfen Ihnen gern

Wir sind dafür da, Ihnen zu helfen.